Ohne die Bereitschaft und Fähigkeit, Daten mit anderen Unternehmen zu tauschen, bleiben viele Chancen der Digitalisierung ungenutzt[1]Fähigkeit, Daten innerhalb von Wertschöpfungsnetzwerken auszutauschen, zentraler Faktor für Wachstum und Erfolg von Unternehmen. Auf Dauer gefährdet das den Fortbestand eines Unternehmens. Im Interview erläutert Raphael Kapsamer (Foto), Junior Sales & Pre-Sales Consultant bei Tributech, warum der sichere Datenaustausch die Basis für neue Services und Geschäftsmodelle ist.

Herr Kapsamer, können Sie uns in wenigen Worten erklären, was Tributech macht?

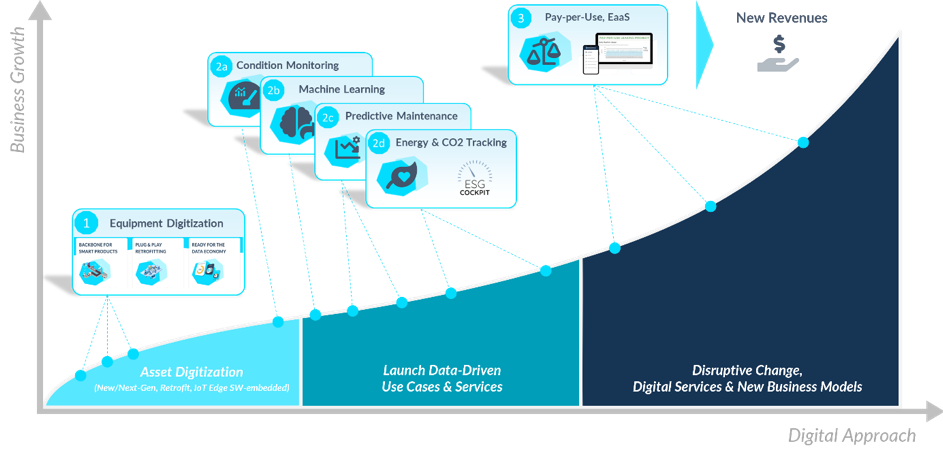

Tributech wurde 2018 gegründet und ist ein Deep-Tech Start Up mit Sitz in Linz, Innsbruck und Wien. Tributech bietet den Unterbau für jegliche digitalen Services speziell im IoT Kontext. Der DataSpace Kit ermöglicht es Unternehmen, Daten schnell und standardisiert zu erfassen und vertrauenswürdig entlang der Wertschöpfungskette zu teilen. Zur besseren Beantwortung Ihrer Frage würde ich gerne eine Grafik benutzen:

Diese Grafik spiegelt den Digitalisierungsgrad eines Unternehmens im IoT Umfeld wider. Im Wesentlichen bietet Tributech den Unterbau, um jede Phase darin zu meistern. Das fängt an beim Retrofitting von bestehenden Assets oder Entwickeln von neuen smarten Produkten, um erstmals Daten zu erfassen bis hin zu neuen digitalen Services wie Pay-per-Use oder Equipment-as-a-Service, bei denen Unternehmen ihr ganzes Geschäftsmodell auf den Daten von Assets oder Produkten aufbauen.

Warum ist der sichere, unternehmensübergreifende Datenaustausch so wichtig?

Ich persönlich vergleiche den Datenaustausch gerne mit dem physischen Warenaustausch zwischen Unternehmen heutzutage. Jede Ware hat eigene Qualitätsnachweise, Ursprungsgarantien und auch genaue Lagerbestimmungen, um höchste Qualität zu gewährleisten. Für den unternehmensübergreifenden Datenaustausch gibt es so etwas noch nicht und gerade wenn Unternehmen basierend auf den Betriebsdaten ihrer Assets einen zusätzlichen Service oder gar ein Geschäftsmodell anbieten wollen, benötigen sie solche Qualitätsnachweise, um sicherstellen zu können, dass die Daten nicht manipuliert worden sind. Da stößt das Teilen von Excel-Tabellen mithilfe von Outlook schnell an seine Grenzen. Genau an diesem Punkt kommt unser DataSpace Kit ins Spiel, mit dem ich Daten nicht nur teilen, sondern auch auf Ursprung und Integrität auditieren kann. Wenn ein Unternehmen z.B. nach produzierten Stück verrechnet, macht es einen sehr großen Unterschied, ob es 10 oder 100 waren.

Wie ist der DataSpace Kit aufgebaut und worin unterscheidet er sich von den eher klassischen Datenaustauschplattformen?

Der DataSpace Kit besteht aus 2 Kernkomponenten: Den DataSpace Agent und die DataSpace Node. Der Agent wird direkt an der Datenquelle, typischerweise auf einem Edge Device oder Embedded Ebene, integriert und hat 3 Fähigkeiten:

- Der Agent zeichnet die Daten auf und synchronisiert sie zur Node.

- Der Agent erstellt für jeden aufgezeichneten Datenpunkt ein dazugehöriges Qualitätssiegel (signieren & hashen). Mithilfe von diesen Qualitätssiegeln können zu jedem späteren Zeitpunkt, auch über Unternehmensgrenzen hinweg, Daten auf Ursprung und Integrität überprüft werden.

- Daten werden mittels dem Open-Source Standard DTDL (Digital Twin Definition Language) kontextualisiert. Diese Kontextinformationen sind für alle nachgelagerten Prozesse wichtig, denn nur smarte Daten sind wertvolle Daten.

Eine Ebene darüber ist die DataSpace Node. Die Node läuft typischerweise in der IT-Infrastruktur des Kunden und fungiert als „Datendrehscheibe“. In dem Web-Interface haben Unternehmen ihre Daten aufliegen und können sehr selektiv, bis auf Datenpunkt-Ebene, spezifische Daten mit anderen Unternehmen teilen. Dafür haben wir einen Publish-Subscribe-Grant-Prozess, wodurch Unternehmen zu jedem Zeitpunkt die Hoheit über ihre Daten haben, auch wenn sie diese teilen.

Zum zweiten Teil Ihrer Frage: Das größte Unterscheidungsmerkmal von Tributech ist zum einen die Möglichkeit Daten sehr selektiv zu teilen und gleichzeitig zu jedem Zeitpunkt die Hoheit über die eigenen Daten zu haben. Was das dem Thema Datenhoheit noch bestärkt ist, dass unsere DataSpace Node typischerweise in der Infrastruktur des Kunden läuft. Das heißt, es gibt keine zentrale Datenhaltung bei Tributech, der Austausch von Daten passiert dezentral zwischen den einzelnen Unternehmen. Zum anderen das Auditieren von Daten über Unternehmensgrenzen hinweg. Genau dort liegt auch das Patent speziell für hochfrequente Sensor- und IoT-Daten.

Wie funktioniert das Geschäftsmodell von Tributech?

Wir fokussieren uns ganz klar auf die Technologie-Lizenzierung, unterstützen aber unsere Kunden und Partner selbstverständlich bei der technologischen Integration und Use-Case Umsetzung mit unseren Consulting- & Engineering Dienstleistungen.

Ad Lizenzkosten: Nachdem unsere Technologie typischerweise als Unterbau für Digitale Services oder neue Geschäftsmodelle eingesetzt wird, ist es uns wichtig die Lizenzkosten am Wert für den Kunden, zu positionieren. Wir haben daher ein Staffel-Pricing, abhängig von der Anzahl an angebundener Assets, entwickelt und möchten mit unserem neuen OEM-Modul auch in die Richtung Royality- bzw. revenue gain/share- Modelle, gehen.

Welchen Aufwand muss ein Unternehmen betreiben, wenn es den DataSpace Kit einsetzen will?

Theoretisch ist der DataSpace Kit in Stunden einsatzbereit 😉 In der Realität ist es natürlich von vielen Faktoren abhängig, die Wenigsten davon sind technologisch. Ein Daten-Ökosystem kann in wenigen Stunden, mittels standardisiertem Cloud Marketplace Deployment, aufgesetzt werden. Die Integration der Datenquellen erfolgt ebenso standardisiert auf Edge-Device Ebene sowohl in Brownfield als auch Greenfield Szenarien und somit können Daten sehr schnell fließen. Wie die Daten dann noch intern, z. B. für AI/ML Workflows, weiterverwertet werden bzw. die Applikation on top, sind dann kundenspezifische Aspekte, die natürlich variieren können.

Ist der DataSpace Kit auch für kleine und mittlere Unternehmen eine Alternative oder ist das nur für große Unternehmen ökonomisch sinnvoll?

Beim DataSpace Kit ist die Unternehmensgröße nicht der entscheidende Faktor, sondern das Commitment und die digitale Reife des Kunden. Das hört sich jetzt abgedroschen an, ich kann es aber begründen: Wir haben zum einen innovative Startups wie Beetle ForTech oder Findustrial, die Ihre Lösung auf unserer Hard- & Software aufbauen und zum anderen Großkonzerne wie RHI Magnesita, die Ihr Predictive Maintenance Service auf unserer Technologie aufbaut.

Welche datengetriebenen Geschäftsmodelle lassen sich mit Tributech umsetzen – können Sie uns einige Beispiele geben?

Unsere Lösung ist grundsätzlich Industrie & Use Case agnostisch. Das bedeutet sie kann als Unterbau für jedes digitale Service im IoT Umfeld verwendet werden. Um es greifbarer zu machen will ich Ihnen ein paar Beispiele geben:

- Condition Monitoring

- Energy & CO² Tracking

- Predictive Maintenance

- Machine Learning & AI

- Pay-per-Use & Equipment-as-a-Service

Warum spielt die Hardware bei Tributech eine vergleichsweise große Rolle?

Dafür gibt es 2 Gründe: Um größtmögliches Vertrauen in Daten zu schaffen ist es nötig, dass wir unseren DataSpace Agent so nahe wie möglich an der Datenquelle, entweder mittels Edge Device oder auf Embedded Ebene, integrieren, damit dieser direkt an der Quelle die Qualitätssiegel erstellt. Wir sind außerdem der Meinung, dass Software-Kompetenz alleine nicht genug ist. Wenn ich mich an dieser Stelle wieder auf die Grafik vorher beziehen darf, ist es speziell in Phase 1 nötig auch Hardware-Kompetenz mitzubringen um Daten von Assets erfassen zu können.

Unser Hardware-Portfolio besteht aus 2 Produkten: Dem Sensor Security Module und dem OEM Module. Das Sensor Security Module ist unser Technologie-Demonstrator – so zusagen ein Plug&Share Device – um in wenigen Schritten Daten von externen Sensoren in der Kundenumgebung verfügbar zu machen. Die Absicherung (Qualitätssiegel) und Kontextualisierung (Digital Twin) kommt hier ganz automatisch mit.

Das OEM Module ist ein Hardware Chip der für die Entwicklung von eigenen IoT Geräten oder smarten Produkten genutzt werden kann und technologisch komplexe Herausforderungen, wie Konnektivität, Update- & Devicemanagement oder IoT Datenmanagement standardisiert löst. Dies führt wiederum zu einer massiv verkürzten Entwicklungsdauer.

Muss ein Kunde das gesamte Paket kaufen, oder besteht die Möglichkeit, einzelne Komponenten zu erwerben?

Die kurze Antwort ist: Ja es ist möglich auch einzelne Komponenten bzw. auch nur einzelne Features in bestehende Lösungen zu integrieren.

Uns ist bewusst, dass wir in den seltensten Fällen „Green Field“ Szenarien haben. Deswegen haben wir unsere Technologie so modularisiert, dass wir bestehende Lösungen mit unseren Features ergänzen können und so für das „Brown Field“ auch gerüstet zu sein. Wir stellen uns da grundsätzlich auch in die 2. Reihe.

Herr Kapsamer, was glauben Sie, wo steht Tributech in fünf Jahren?

Wenn ich einen Blick in die Glaskugel werfen soll, dann sehe ich sehr großes Potenzial für die Technologie, aber das muss ich fast sagen 😉

Spaß bei Seite. Ich bin davon überzeugt, dass in Zukunft der unternehmensübergreifende Datenaustausch und die Möglichkeit Daten wie jedes andere physische Gut zu qualifizieren und zu verwalten einen enormen Einfluss auf den Erfolg eines Unternehmens haben wird. Damit verbunden, ist es meiner Meinung nach unumgänglich, dass Unternehmen ein gewisses Qualitätssiegel für geteilte Daten haben wollen, das bestätigt, dass diese nicht verändert wurden. Warum ist das wichtig? Wenn der Wert von Daten zukünftig auch den Weg in die Bilanzen finden soll, dann ist das Sicherstellen von Ursprung und Integrität unumgänglich. Man bilanziert ja auch keine Maschinen, Fabriken und Immobilien, wo man sich nicht sicher ist, ob es sie überhaupt gibt und in welchem Zustand sie sind.

Besten Dank für das Gespräch!

Ich bedanke mich recht herzlich Herr Keuper!

Zuerst erschienen auf Sicherer Datenaustausch in der Industrie (SDI)

References